Warum dauerhafte Datenbereinigung keine Lösung ist!

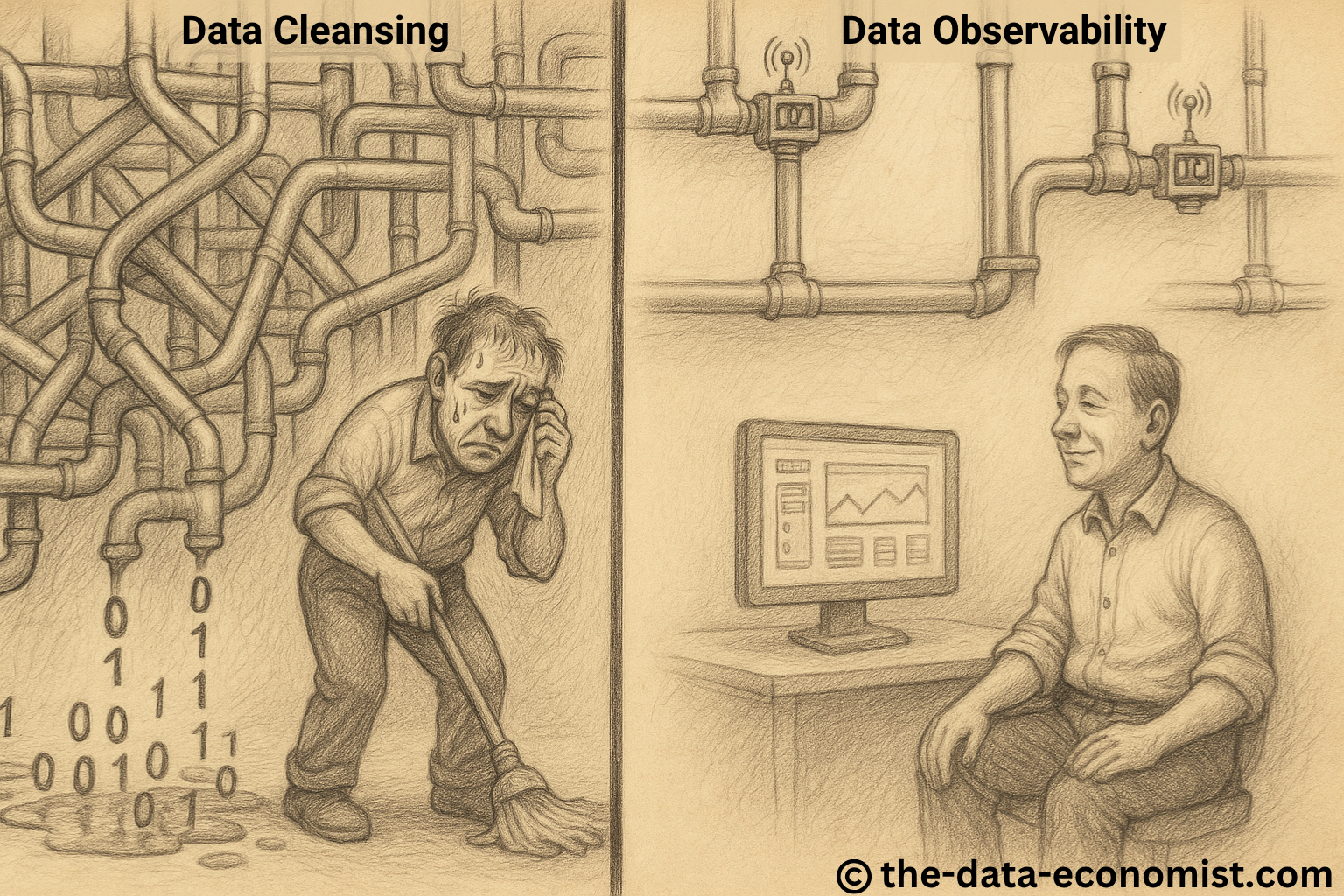

Data Cleansing vs. Data Observability

Datenbereinigung ist keine Lösung, sondern ein Symptom einer mangelhaft aufgestellten Datenstrategie sowie ineffizienter, nicht gut funktionierender Prozesse. Viele Unternehmen investieren erhebliche Ressourcen in kontinuierliche Bereinigungsmaßnahmen – ohne die eigentlichen Ursachen der schlechten Datenqualität nachhaltig zu beseitigen. Doch wer ständig nur putzt, ohne das Leck in der Leitung zu schließen, wird nie trocken arbeiten können.

Praxisbeispiel: Datenqualität bei Vertriebspartnern

In der Unternehmensrealität zeigt sich häufig, dass gerade Kundendaten, die von Geschäftspartnern erhoben und geliefert werden, gravierende Qualitätsmängel aufweisen. Aus meiner Erfahrung als Director Data Governance & Strategy bei einem Telekommunikationsunternehmen erinnere ich mich an eine Datenqualitätsanalyse, die deutlich machte: Die von unseren Vertriebspartnern gelieferten Kundendaten waren erheblich schlechter als die vom eigenen Vertrieb erhobenen. Das war besonders kritisch, da ein Drittel unseres Umsatzes über Geschäftspartner generiert wurde – die Qualität dieser Daten hatte damit direkten Einfluss auf unseren Geschäftserfolg. Trotz hoher Marketingbudgets, die diesen Partnern zur Kundengewinnung bereitgestellt wurden, blieben Erfolge oft aus, da die schlechte Datenqualität die Wirksamkeit der Kampagnen erheblich beeinträchtigte. Darüber hinaus war die stetige Datenbereinigung sehr kostenintensiv. Daher setzten wir uns mit den Business Partnern zusammen und änderten die Verträge sowie das Anreizsystem so, dass die Partner ein hohes Interesse daran hatten, von Beginn an eine hohe Datenqualität zu liefern.

Warum reaktives Handeln nicht genügt

Das Kernproblem liegt darin, dass Datenqualität zu oft nur reaktiv behandelt wird – ähnlich wie das ständige Wischen eines überfluteten Bodens, ohne das defekte Rohr zu reparieren. Unternehmen investieren in teure Bereinigungsmaßnahmen, statt die Ursachen anzugehen: fehlerhafte Prozesse, unklare Zuständigkeiten, mangelhafte Anreize. Hinzu kommt, dass Geschäftspartner meist keine Verpflichtung verspüren, ihre Datenqualität eigenverantwortlich zu verbessern – denn die Kosten und die Verantwortung bleiben oft beim Unternehmen.

Anreizsysteme als Hebel zur Veränderung

Ein wirkungsvoller Lösungsansatz liegt in der Neugestaltung der Partnerschaftsvereinbarungen: Geschäftspartner sollten nur dann in höhere Statusstufen (z. B. Bronze, Silber, Gold, Platin) aufsteigen und Zugang zu attraktiveren Marketingbudgets erhalten, wenn sie qualitativ hochwertige Kundendaten liefern. Dieser Ansatz führte in der Praxis rasch zu einer deutlichen Qualitätssteigerung. Die Partner profitierten von besseren Ergebnissen, das Unternehmen von niedrigeren Bereinigungskosten und erfolgreicheren Kampagnen. Entscheidend dabei ist, Anreize so zu setzen, dass sie die Bereitschaft fördern, Prozesse und Strukturen, aus denen die Daten hervorgehen, konsequent zu verbessern.

Prozessdesign als Fundament verlässlicher Daten

Gute Datenqualität beginnt nicht beim Datensatz, sondern beim Prozessdesign. Schlechte Daten sind häufig die Folge schlecht definierter, lückenhafter oder ineffizienter Abläufe. Nur wenn Prozesse von Anfang an klar, konsistent und fehlerresistent gestaltet sind, entstehen Daten, auf die sich Unternehmen verlassen können. Umgekehrt ist auch eine schlechte Datenlage aufschlussreich: Sie zeigt, dass ein zugrunde liegender Prozess nicht gut funktioniert – eine wertvolle Erkenntnis, die zum Ausgangspunkt für gezielte Verbesserungen werden kann.

Data Observability: Transparenz schafft Vertrauen

Ein weiterer Schlüssel zur nachhaltigen Datenqualität ist das Konzept der Data Observability. Es umfasst die kontinuierliche Überwachung, Verwaltung und Pflege von Daten über verschiedene Prozesse, Systeme und Pipelines hinweg, um ihre Qualität, Verfügbarkeit und Zuverlässigkeit sicherzustellen. Diese kontinuierliche Transparenz wirkt wie ein strategisches Frühwarnsystem: Wenn Daten unvollständig, verspätet oder im falschen Format eintreffen, kann sofort reagiert werden – bevor falsche Entscheidungen getroffen oder Systeme gestört werden.

Gerade in Kombination mit automatisierten Prozessen oder KI-basierten Anwendungen ist Data Observability unerlässlich. Sie hilft, Muster schlechter Datenqualität zu identifizieren, strukturelle Ursachen sichtbar zu machen und operative Risiken frühzeitig zu minimieren. Damit wird Data Observability zur Schnittstelle zwischen technischer Präzision und strategischer Steuerung – und macht es Unternehmen möglich, Daten als echten Wettbewerbsfaktor zu nutzen.

Fazit: Ursachenorientiert statt symptombezogen handeln

Dauerhafte Datenbereinigung ist teuer, ineffizient und löst nicht das eigentliche Problem. Unternehmen müssen Datenqualität als strategische Kernaufgabe begreifen. Dazu gehören klar definierte Verantwortlichkeiten und vor allem gezielte Anreize, die über reine Qualitätsmetriken hinausgehen und zur Verbesserung der zugrunde liegenden Prozesse und Strukturen motivieren. Nur ein solcher, ursachenorientierter Ansatz kann punktuelle Korrekturen in eine ganzheitliche, datenorientierte Transformation überführen – und damit langfristig echten Geschäftswert schaffen.

Weitere interessante Artikel:

- Advisory | Impulse Talks | Trainings

- Ganzheitliches Data Management Model 5.0

- Data Governance: Der schlafende Riese, der unsere KI-Zukunft sichert

- Data & AI Governance – Assistenzsystem einer erfolgreichen Transformation zur Data Inspired Culture

- Das Data Governance Wheel: Navigieren zum Erfolg

- Data Governance Value

Datenqualität, Datenqualitätsmanagement, Datenlogistik, Data Quality Management, Data Strategy, Data Management, Data Quality and AI, Data Quality Strategy, Data Cleansing, Data Observability

- Geändert am .

- Aufrufe: 1581