Ganzheitliches Data Management Model 5.0

Die moderne Architektur für Daten- und KI-orientierte Unternehmen

Einleitung

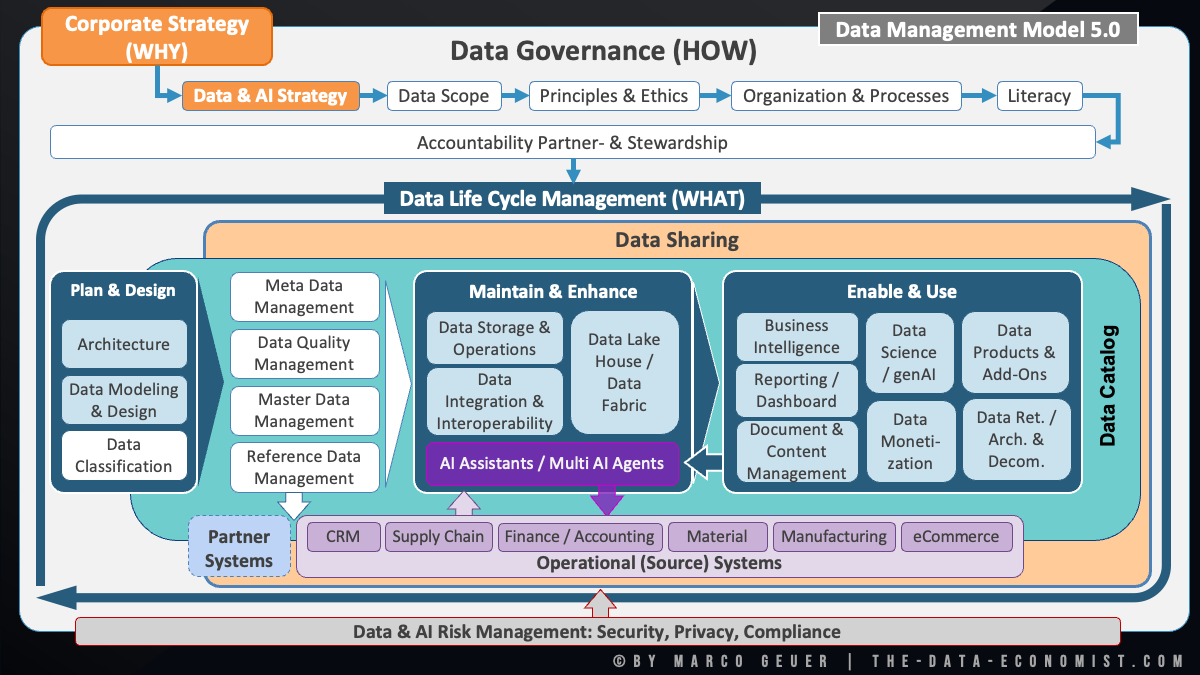

Die zunehmende Bedeutung von Daten und künstlicher Intelligenz (KI) stellt Unternehmen vor die Herausforderung, ihr Data Management nicht nur technisch, sondern auch organisatorisch und strategisch neu auszurichten. Das Data Management Model 5.0 bietet einen zeitgemäßen, ganzheitlichen Rahmen, der die Integration von Daten, Governance, KI und Wertschöpfung in einem klar strukturierten Gesamtbild abbildet.

1. Vom „Warum“ zum „Wie“: Verbindung von Unternehmensstrategie und Data & AI Strategy

Im Zentrum des Modells steht die Corporate Strategy (WHY). Sie definiert die übergeordneten Ziele und den Geschäftsnutzen. Daraus abgeleitet folgt die Data & AI Strategy, die festlegt, wie Daten und KI zur Umsetzung dieser Unternehmensziele beitragen.

Die Data & AI Strategy übersetzt sich in vier zentrale Steuerungsdimensionen:

-

Data Scope – Welcher Datenumfang ist relevant?

-

Principles & Ethics – Nach welchen Werten und Leitplanken wird gehandelt?

-

Organization & Processes – Welche Strukturen und Abläufe sichern nachhaltiges Datenmanagement?

-

Literacy – Wie werden Daten- und KI-Kompetenzen im Unternehmen aufgebaut und gefördert?

Accountability und Stewardship sind als übergreifende Prinzipien fest verankert und sichern Verantwortlichkeit und eine nachhaltige Datenkultur.

2. Data Governance als Steuerungsinstrument (HOW)

Data Governance ist das Bindeglied zwischen Strategie und operativer Umsetzung. Sie definiert das „HOW“ – also, wie Datenmanagement effektiv, ethisch und wertschöpfend umgesetzt wird. Governance umfasst dabei:

-

Klare Rollen und Verantwortlichkeiten (Accountability Partner & Stewardship)

-

Verbindliche Regeln und Standards

-

Förderung einer Daten- und KI-Literacy

Die Data Governance-Bausteine im Modell – Einordnung der weißen und übergreifenden Elemente

Im Data Management Model 5.0 werden verschiedene zentrale Funktionen als Bausteine der Data Governance verstanden:

-

Die weißen Bausteine im Modell – darunter Data Classification, Meta Data Management, Data Quality Management sowie Master & Reference Data Management – stehen exemplarisch für zentrale Governance-Funktionen, die entlang des gesamten Data Life Cycles gezielt zur Anwendung kommen. Sie sichern Transparenz, Qualität, Nachvollziehbarkeit, Dokumentation und Compliance in allen Phasen.

-

Ergänzend gibt es übergreifende Governance-Bausteine wie Data Catalog und Data Sharing. Sie sind im Modell farblich anders gekennzeichnet, nehmen jedoch eine ebenso tragende Rolle im Rahmen der Data Governance ein. Der Data Catalog sorgt als zentrales Verzeichnis für Transparenz, Orientierung und Auffindbarkeit im Datenbestand, während Data Sharing die gezielte, regelkonforme und wertschöpfende Nutzung von Daten über Abteilungs- und Unternehmensgrenzen hinweg ermöglicht.

Gemeinsam bilden diese Funktionen das Rückgrat einer nachhaltigen, unternehmensweiten Data Governance. Ihre Steuerung und Umsetzung an den relevanten Stellen des Life Cycles ermöglicht ein effektives, sicheres und innovationsförderndes Datenmanagement.

3. Data Life Cycle Management (WHAT): Das operative Herzstück

Der operative Kern des Modells ist das Data Life Cycle Management, das in drei zentrale Phasen unterteilt ist:

a) Plan & Design

-

Architektur: Grundlegende Struktur für die Datenlandschaft.

-

Data Modeling & Design: Entwurf der Datenmodelle und Strukturen.

-

Data Classification: Kategorisierung, Bewertung und Zuordnung von Sensitivitätsleveln für Daten (z. B. öffentlich, intern, vertraulich, streng vertraulich).

b) Maintain & Enhance

-

Meta Data Management: Verwaltung von Metadaten zur Sicherstellung der Transparenz – z. B. für Data Catalogs, Kontextinformationen für AI Assistants und Multi-Agenten sowie zur systematischen Dokumentation, Nachweisführung und kontinuierlichen Verbesserung.

-

Data Quality Management: Sicherstellung, Überwachung und kontinuierliche Verbesserung der Datenqualität – einschließlich Dokumentation von Qualitätsstandards, Prüfprozessen und Nachweisführung. Besonders wirkungsvoll sind diese Maßnahmen, wenn sie bereits direkt in den operativen Systemen ansetzen und dort für verlässliche und konsistente Daten sorgen.

-

Master & Reference Data Management: Verwaltung konsistenter Stamm- und Referenzdaten.

-

Data Storage & Operations / Data Lake House / Data Fabric: Modernes Datenmanagement auf Plattform-Ebene.

-

Data Integration & Interoperability: Sicherstellung eines nahtlosen Austauschs und der Vernetzung von Datenquellen.

-

AI Assistants / Multi AI Agents: Automatisierte Unterstützung bei Datenmanagement- und Analyseprozessen – einschließlich Automatisierung von Routineaufgaben, Optimierung von Prozessen sowie Entscheidungsunterstützung durch KI-basierte Analysen und bedarfsgerechte autonome Echtzeitentscheidungen.

c) Enable & Use

-

Business Intelligence / Reporting & Dashboarding: Datenbasiertes Reporting und Entscheidungsunterstützung.

-

Document & Content Management: Verwaltung und Nutzung unstrukturierter Inhalte – inklusive systematischer Dokumentation sowie Erfüllung von Nachweis- und Aufbewahrungspflichten.

-

Data Science / genAI: Nutzung moderner Analyse- und KI-Technologien.

-

Data Products & Add-Ons: Entwicklung und Betrieb von Daten-Produkten und Erweiterungen.

-

Data Monetization: Wertschöpfung durch gezielte Nutzung und Vermarktung von Daten sowie daten- und KI-basierten Produkten und Lösungen, wie z. B. Vorhersage-, Empfehlungs- und Support-Systemen.

-

Data Retention, Archiving & Decommissioning: Regelkonforme Datenhaltung, Archivierung und Löschung.

4. Integration operativer Systeme und Partner

Das Modell unterscheidet explizit zwischen zwei Integrationssichten:

-

Integration eingesetzter operativer Systeme innerhalb des Unternehmens (z. B. CRM, Supply Chain, Finance, Material, Manufacturing, eCommerce). Diese bilden die reale Komplexität und Heterogenität moderner Unternehmens-IT ab und sind elementar für interne Geschäftsprozesse und Wertschöpfungsketten.

-

Integration externer Partner-Systeme, also den Datenaustausch und die Zusammenarbeit mit Partnern außerhalb des Unternehmens. Hier steht die übergreifende Verknüpfung, Dateninteroperabilität und Kollaboration mit Lieferanten, Kunden oder Partnern im Fokus.

Daten fließen somit nicht isoliert, sondern sind sowohl in interne Prozesse als auch in externe Wertschöpfungsnetzwerke und Partnerschaften eingebettet.

5. Data Catalog – Das zentrale Verzeichnis für Unternehmensdaten

Der Data Catalog ist das Herzstück für Transparenz, Auffindbarkeit und Governance im modernen Data Management. Ein Data Catalog bildet eine zentrale Übersicht über alle strukturierten und unstrukturierten Datenbestände eines Unternehmens. Er ermöglicht:

-

Durchgängige und gezielte Suche nach Datenressourcen

-

Sichtbarkeit und Kontext zu Datenherkunft (Provenance), Qualität und Zugriffsrechten

-

Verknüpfung mit Metadatenmanagement und Governance-Anforderungen

-

Unterstützung bei der Einhaltung regulatorischer Vorgaben und Nachweispflichten

-

Basis für effizientes Data Sharing und datenbasierte Zusammenarbeit

Der Data Catalog bildet damit die Grundlage für eine datengetriebene und kollaborative Organisation, in der sowohl Business- als auch IT-Anwender schnell die für sie relevanten Daten identifizieren, bewerten und nutzen können.

6. Data Sharing als verbindendes Element

Data Sharing ist das zentrale verbindende Element des Data Management Model 5.0. Es beschreibt die Fähigkeit und Bereitschaft, Daten sowohl intern (zwischen Abteilungen und Systemen) als auch extern (mit Partnern, Kunden, Lieferanten) sicher, transparent und effizient zu teilen.

Zentrale Aspekte von Data Sharing:

-

Offenheit und Interoperabilität: Daten werden so bereitgestellt, dass sie organisationsübergreifend genutzt werden können.

-

Regelbasierter Zugang: Zugriff erfolgt nach Governance-Vorgaben, Rollen und Zugriffsrechten.

-

Transparenz und Nachvollziehbarkeit: Data Catalogs und Metadatenmanagement machen jederzeit nachvollziehbar, welche Daten verfügbar sind und wie sie genutzt werden dürfen.

-

Vertrauensvolle Kollaboration: Data Sharing ermöglicht neue Formen der Zusammenarbeit und Wertschöpfung, ohne Risiken wie Datenschutzverletzungen oder Kontrollverlust einzugehen.

-

Enablement von Self-Service und KI: Erst Data Sharing macht Self-Service Analytics, KI-basierte Prozesse und Innovationen unternehmensweit möglich.

Data Sharing schlägt die Brücke zwischen operativen Systemen, Fachbereichen und externen Partnern und trägt entscheidend dazu bei, das Datenpotenzial umfassend und verantwortungsvoll zu heben.

7. Data & AI Risk Management als zentrale Schutzebene

Alle Aktivitäten im Data Management stehen unter dem Schutzschirm eines ganzheitlichen Data & AI Risk Managements. Schwerpunkte sind dabei:

-

Security

-

Privacy

-

Compliance

Dies ist essenziell, um Risiken zu beherrschen und den regulatorischen Anforderungen – etwa durch EU AI Act und DSGVO – zu entsprechen.

8. Zentrale Erfolgsfaktoren für modernes Data Management

-

Ganzheitlicher Ansatz: Verknüpfung von Strategie, Governance, Lifecycle und operativer Umsetzung.

-

Interdisziplinarität: Zusammenwirken von Business, IT, Prozessen und Data Management.

-

Klar definierte Verantwortlichkeiten und Rollen.

-

Fokus auf Datenqualität und Wertschöpfung.

-

Integration von KI als Hebel für Effizienz und Innovation.

-

Literacy & Kultur: Kontinuierliche Weiterentwicklung der Daten- und KI-Kompetenz im Unternehmen sowie einer Data Inspired Leadership Kultur.

-

Sicherstellung von Datenschutz, Sicherheit und Compliance.

Fazit

Das Data Management Model 5.0 steht für ein modernes, strategisch integriertes und um KI erweitertes Verständnis von Datenmanagement. Es macht deutlich: Nur wer Datenstrategie, Governance, Lifecycle und Wertschöpfung konsequent zusammendenkt und in der Organisation verankert, kann Daten und KI als echten Wettbewerbsvorteil nutzen und nachhaltige Innovationen ermöglichen.

Weitere interessante Artikel:

- Advisory | Impulse Talks | Trainings

- Data Catalogue – Beschleuniger der Datenkompetenz (Data Literacy)

- Data & AI Governance – Assistenzsystem einer erfolgreichen Transformation zur Data Inspired Culture

- Data Governance und Künstliche Intelligenz – Der Weg zu einem datengesteuerten 360-Grad-Kundenservice

- Data Governance: Der schlafende Riese, der unsere KI-Zukunft sichert

Master Data Management, Data Governance, Data Catalog, Data Strategy, Data Management, AI Strategy, Data & AI Strategy, Data Sharing, Meta Data Management

- Geändert am .

- Aufrufe: 2710